Sommario:

- Autore Stanley Ellington [email protected].

- Public 2023-12-16 00:19.

- Ultima modifica 2025-01-22 16:02.

In modo da servire un modello Tensorflow , esporta semplicemente un modello salvato dal tuo Tensorflow programma. SavedModel è un formato di serializzazione ermetico, recuperabile e indipendente dal linguaggio che consente a sistemi e strumenti di livello superiore di produrre, consumare e trasformare Modelli TensorFlow.

Di conseguenza, come posso eseguire un modello TensorFlow?

Questi sono i passaggi che faremo:

- Fai un modello stupido come esempio, addestralo e conservalo.

- Recupera le variabili di cui hai bisogno dal tuo modello memorizzato.

- Costruisci le informazioni sul tensore da loro.

- Crea la firma del modello.

- Crea e salva un generatore di modelli.

- Scarica un'immagine Docker con TensorFlow già compilata su di essa.

Inoltre, a cosa serve TensorFlow? Servizio TensorFlow è un flessibile, ad alte prestazioni servendo sistema per modelli di machine learning, progettato per ambienti di produzione. Servizio TensorFlow fornisce un'integrazione pronta all'uso con TensorFlow modelli, ma può essere facilmente esteso a servire altri tipi di modelli e dati.

A questo proposito, come funziona TensorFlow serve?

Servizio TensorFlow ci consente di selezionare quale versione di un modello o "servibile" vogliamo utilizzare quando effettuiamo richieste di inferenza. Ogni versione verrà esportata in una sottodirectory diversa nel percorso specificato.

Che cos'è un server modello?

Server modello per Apache MXNet (MMS) è un componente open source progettato per semplificare l'attività di implementazione del deep learning Modelli per l'inferenza su scala. Distribuzione Modelli perché l'inferenza non è un compito banale.

Consigliato:

Come si trova il modello della spesa per interessi?

Modellare la spesa per interessi futuri come il costo medio del debito moltiplicato per l'importo medio del debito sullo stato patrimoniale in ogni anno. Questo è solitamente calcolato come: (Saldo iniziale del debito + Saldo finale del debito) ÷ 2

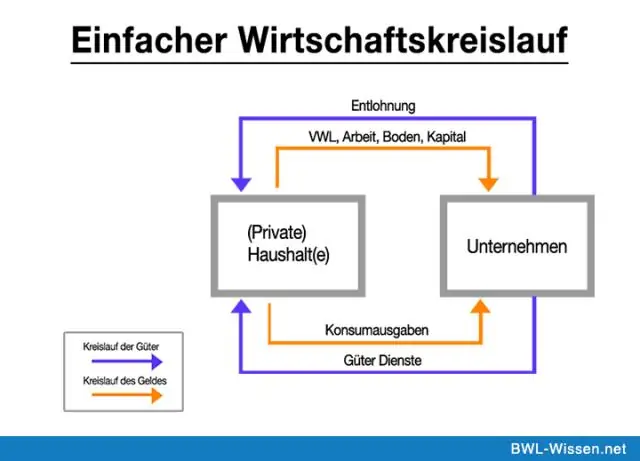

Come funziona un modello di flusso circolare?

Il modello del flusso circolare dimostra come il denaro si muove attraverso la società. Il denaro fluisce dai produttori ai lavoratori come salario e ritorna ai produttori come pagamento per i prodotti. In breve, un'economia è un flusso circolare infinito di denaro

In che modo il modello Ramsey è diverso dal modello Solow?

Il modello Ramsey-Cass-Koopmans differisce dal modello Solow-Swan in quanto la scelta del consumo è esplicitamente microfondata in un determinato momento e quindi endogena il tasso di risparmio. Di conseguenza, a differenza del modello Solow-Swan, il tasso di risparmio potrebbe non essere costante durante la transizione allo stato stazionario di lungo periodo

Qual è la differenza tra il modello a cascata e il modello iterativo?

Il modello a cascata pura sembra una cascata in quanto ogni passaggio è una fase diversa. Le modifiche in un processo Waterfall seguirebbero una procedura di gestione delle modifiche controllata da un comitato di controllo delle modifiche. Il modello iterativo è quello in cui ci sono più di 1 ripetizione delle fasi di attività in un processo

Qual è la differenza tra modello del fair value e modello di rivalutazione?

Diverso dal modello del valore equo non ha l'ammortamento mentre il modello di rivalutazione ha l'ammortamento. Se c'è un guadagno nel modello del valore equo per gli investimenti immobiliari, è il guadagno è anche chiamato come guadagno da rivalutazione che è lo stesso per il modello di rivalutazione per ppe???